Réunion

Théorie du deep learning

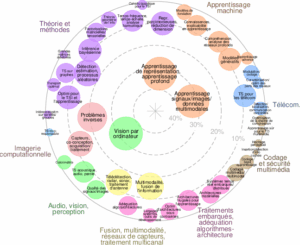

Axes scientifiques :

- Théorie et méthodes

- Apprentissage machine

Organisateurs :

Nous vous rappelons que, afin de garantir l'accès de tous les inscrits aux salles de réunion, l'inscription aux réunions est gratuite mais obligatoire.

La réunion sera également accessible en distanciel mais l'inscription est obligatoire

Inscriptions

0 personnes membres du GdR IASIS, et 0 personnes non membres du GdR, sont inscrits à cette réunion.

Capacité de la salle : 600 personnes. Nombre d'inscrits en présentiel : 0 ; Nombre d'inscrits en distanciel : 0

600 Places restantes

Inscriptions closes pour cette journée

Annonce

En dépit du succès actuel du deep learning, les garanties théoriques associées à ces modèles décisionnels restent fragiles. Ces questions posent des enjeux majeurs pour la communauté en traitement du signal et des images.

L’objectif de cette journée est de faire un état des lieux des avancées récentes pour l’analyse formelle du fonctionnement des réseaux de neurones profonds. Nous lançons un appel à communication sur l’analyse théorique du deep learning, et centré sur les thèmes (non exhaustifs) suivants :

- Théorie de la généralisation (double descente, régularisation implicite, réseaux sur-paramétrisés)

- Robustesse décisionnelle (incertitude, stabilité, propriétés Lipschitz)

- Expressivité des modèles, compression des réseaux

Orateurs invités

- Mikhail Belkin, Univerity of California San Diego

- Gérard Biau, Sorbonne Université, Sorbonne Center for Artificial Intelligence (SCAI)

Appel à contributions

Les personnes souhaitant présenter leurs travaux à cette journée sont invitées à envoyer, par e-mail, leur proposition (titre et résumé de 1 page maximum) aux organisateurs avant le 31 Mai 2021.

Organisateurs

- Caroline Chaux (caroline.chaux@univ-amu.fr), Université Aix-Marseille, I2M

- Valentin Emiya (valentin.emiya@lis-lab.fr), Université Aix-Marseille, LIS

- François Malgouyres (Francois.Malgouyres@math.univ-toulouse.fr), Institut de Mathématiques de Toulouse (IMT, CNRS UMR 5219)

- Nicolas Thome (nicolas.thome@cnam.fr), Cnam Paris

- Konstantin Usevich (konstantin.usevich@univ-lorraine.fr), CRAN, Nancy

Programme

- Session 1 : 10h-12h

- 10h (invited talk): Some Theoretical Insights into Wasserstein GANs by Gérard Biau (Sorbonne Université)

- 10h45: Existence, Stability And Scalability Of Orthogonal Convolutional Neural Networks by El-Mehdi Achour (Institut de Mathématiques de Toulouse)

- 11h05: A Neural Tangent Kernel Perspective of GANs by Jean-Yves Franceschi (Sorbonne Université, LIP6)

- 11h25: Achieving robustness in classification using optimal transport with hinge regularization by Mathieu Serrurier (IRIT)

- 11h45: Encoding the latent posterior of Bayesian Neural Networks for uncertainty quantification by Gianni Franchi (ENSTA)

- 12h05: Towards Building a Heavy-Tailed Theory of Stochastic Gradient Descent for Deep Neural Networks by Umut Simsekli (Inria)

- 12h25: end

- Session 2 : 16-18h

- 16h: Tensor-based approaches for learning flexible neural networks by Yassine Zniyed (Université de Lorraine)

- 16h20: Fixed support matrix factorization is NP hard by Tung Le Quoc (ENS de Lyon)

- 16h40: Analyzing the identifiability of sparse linear networks by Léon Zheng (ENS de Lyon)

- 17h (invited talk): From classical statistics to modern machine learning by Mikhail Belkin (UCSD)

- 17h45: Spherical Perspective on Learning with Batch Normalization by Simon Roburrin (LIGM)

- 18h05: end

282 personnes membres du GdR ISIS, et 262 personnes non membres du GdR, sont inscrits à cette réunion.

Résumés des contributions

Some Theoretical Insights into Wasserstein GANs (invited talk) by Gérard Biau (Sorbonne Université)

Generative Adversarial Networks (GANs) have been successful in producing outstanding results in areas as diverse as image, video, and text generation. Building on these successes, a large number of empirical studies have validated the benefits of the cousin approach called Wasserstein GANs (WGANs), which brings stabilization in the training process. In the present contribution, we add a new stone to the edifice by proposing some theoretical advances in the properties of WGANs. First, we properly define the architecture of WGANs in the context of integral probability metrics parameterized by neural networks and highlight some of their basic mathematical features. We stress in particular interesting optimization properties arising from the use of a parametric 1-Lipschitz discriminator. Then, in a statistically-driven approach, we study the convergence of empirical WGANs as the sample size tends to infinity, and clarify the adversarial effects of the generator and the discriminator by underlining some trade-off properties. These features are finally illustrated with experiments using both synthetic and real-world datasets.

This is a joint work with Maxime Sangnier (Sorbonne University) and Ugo Tanielian (Sorbonne University & Criteo)