Informations générales

- Sujet : Analyse multimodale des interactions humaines

- Mots-clés : Intelligence artificielle, représentations multimodales, analyse computationnelle des interactions humaines, psychologie sociale expérimentale.

- Contrat : Contrat doctoral de 36 mois entièrement financé dans le cadre du projet ANR « CMiO ».

- Salaire : 2200 euros brut par mois.

- Date de début : Dès que possible.

- Lieu : Campus de Rennes de CentraleSupélec.

- Affiliations : Laboratoire IETR (UMR CNRS 6164) et LP3C, Université Rennes 2.

- Directeurs de thèse : Renaud Séguier, co-directeur : Alain Somat

- Encadrants de thèse : Simon Leglaive et Kévin Nadarajah

- Contact : simon.leglaive@centralesupelec.fr, kevin.nadarajah@cerema.fr

- Date limite : Les candidatures seront traitées au fil de l’eau jusqu’à sélection d’un·e candidat·e.

Description et objectifs

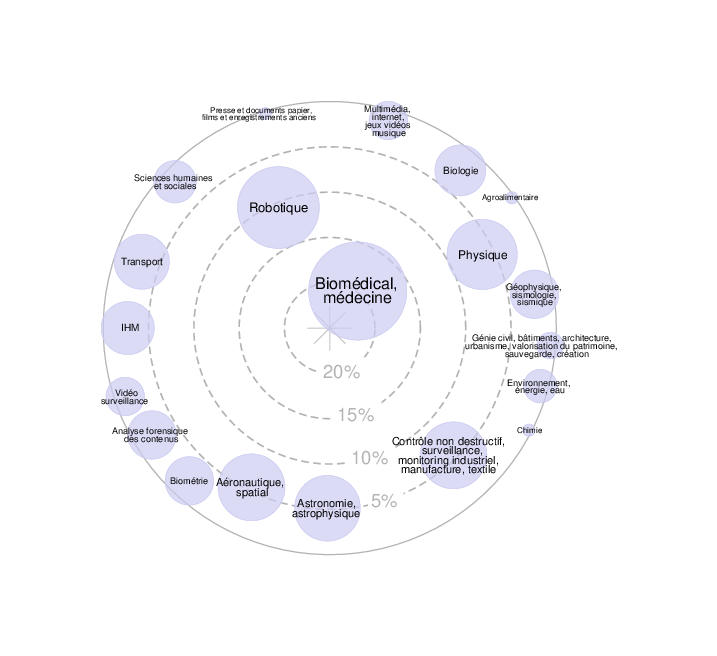

Ce sujet de thèse porte sur l’analyse multimodale des interactions humaines. A partir d’un enregistrement vidéo, il s’agit de développer des méthodes objectives d’analyse du comportement humain afin de caractériser une interaction impliquant plusieurs individus, en particulier dans le cadre de discussions de groupe.

Cette thèse se positionne à l’intersection des domaines de l’intelligence artificielle et de la psychologie sociale expérimentale. Les objectifs de la thèse sont par conséquent doubles :

- Développer des méthodes d’extraction ou d’apprentissage de représentations du comportement humain dans une vidéo, en exploitant plusieurs modalités, y compris la parole audiovisuelle, les expressions faciales, et la posture humaine. Pour atteindre cet objectif nous envisageons de nous appuyer sur nos travaux récents portant sur l’apprentissage de représentations latentes et les modèles génératifs appliqués au traitement de la parole audiovisuelle (Sadok et al., 2023a; 2023b; 2024) et à l’estimation de la posture et de la forme du corps humain (Fiche, 2024; 2025).

- Analyser la représentation apprise pour évaluer l’alignement des postures dans les interactions humaines. Dans le cadre du projet CMiO mentionné plus haut, il s’agit d’identifier, de capter puis de traiter automatiquement les indicateurs comportementaux de l’engagement des parties prenantes d’une controverse dans le but de prédire une posture d’ouverture (Nadarajah et al., 2024) que l’on sait susceptible d’offrir à chacun la possibilité d’être entendu et de construire ensemble une position concertée inédite, le débat devient ainsi un échange gagnant-gagnant permettant aux participants de converger vers une décision commune satisfaisante pour tous.

Pour permettre ces deux objectifs, le travail de thèse débutera par un état de l’art dans le domaine de l’analyse computationnelle des interactions humaines, en particulier dans le cadre de discussions de groupe (e.g., dyades, débats, controverses, etc.).

Profil de candidat·e

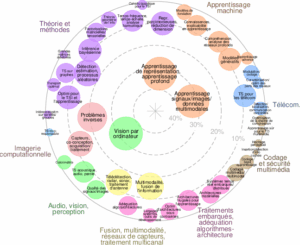

Le/la candidat·e doit être titulaire d’un master ou d’un diplôme d’ingénieur, avec une solide formation en apprentissage statistique et/ou traitement du signal et/ou vision par ordinateur, et de bonnes compétences en programmation Python.

Il/elle doit avoir un intérêt prononcé pour les sciences humaines, en particulier dans le cadre applicatif en psychologie sociale expérimentale. Une formation complémentaire dans ces domaines constituerait un atout. Cet intérêt pour les sciences humaines devra être motivé explicitement dans le dossier de candidature.

Le/la candidat·e doit également avoir d’excellentes compétences de communication orale et écrite, avec un niveau de français minimum C1 selon le cadre européen commun de référence pour les langues (CECRL).

Environnement de travail

Le/la doctorant·e intègrera l’équipe AIMAC du laboratoire IETR située sur le campus de Rennes de CentraleSupélec et sera amené·e à travailler au laboratoire LP3C, Université Rennes 2. Il/elle sera encadré·e par Simon Leglaive et Renaud Séguier pour les aspects IA/signal/vision et par Kévin Nadarajah et Alain Somat pour les aspects psychologie sociale expérimentale.

Le/la doctorant·e bénéficiera de l’environnement de recherche de CentraleSupélec, en particulier des ressources de calcul de Ruche, le cluster HPC du centre de calcul « Mésocentre » de l’Université Paris-Saclay, de CentraleSupélec et de l’École Normale Supérieure Paris-Saclay.

CentraleSupélec dispose d’une résidence étudiante sur le campus avec des studios disponibles à la location.

Comment postuler ?

Les candidat·e·s intéressé·e·s doivent postuler en remplissant le formulaire suivant : https://forms.gle/jeemuZhP1pzuB2cz9

Les candidat·e·s seront invité·e·s à charger sous forme de fichiers PDF un curriculum vitae, une courte lettre de motivation, les relevés de notes officiels pour chaque année d’études supérieures, ainsi qu’une à trois lettres de recommandation. En cas de difficulté ou de question, veuillez contacter simon.leglaive@centralesupelec.fr et kevin.nadarajah@cerema.fr

Références

Fiche, G., Leglaive, S., Alameda-Pineda, X., Agudo, A., & Moreno-Noguer, F. (2024). VQ-HPS: Human pose and shape estimation in a vector-quantized latent space. In European Conference on Computer Vision (ECCV).

Fiche, G., Leglaive, S., Alameda-Pineda, X., & Moreno-Noguer, F. (2025). MEGA: Masked generative autoencoder for human mesh recovery. In IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).

Nadarajah, K., Brun, L., Bordel, S., Ah-Tchine, E., Dumesnil, A., Mourato, A. M., Py, J., Jammes, L., Arnauld De Sartre, X., & Somat, A. (2024). A Three-Stage Psychosocial Engineering-Based Method to Support Controversy and Promote Mutual Understanding between Stakeholders : The Case of CO2 Geological Storage. Energies, 17(5), Article 5. https://doi.org/10.3390/en17051014

Sadok, S., Leglaive, S., & Séguier, R. (2023a). A vector quantized masked autoencoder for speech emotion recognition. In IEEE ICASSP 2023 Workshop on Self-Supervision in Audio, Speech and Beyond (SASB),.

Sadok, S., Leglaive, S., & Séguier, R. (2023b). A vector quantized masked autoencoder for audiovisual speech emotion recognition. arXiv preprint arXiv:2305.03568.

Sadok, S., Leglaive, S., Girin, L., Alameda-Pineda, X., & Séguier, R. (2024). A multimodal dynamical variational autoencoder for audiovisual speech representation learning. Neural Networks, 172, 106120.