Laboratoire IMS, CNRS – Bordeaux Sciences Agro

Mots clés : deep learning, classification, segmentation sémantique, régression, persillé de la viande.

Enjeux

L’intelligence artificielle et la vision par ordinateur transforment aujourd’hui des secteurs aussi variés que la santé, l’automobile, la robotique… et même l’agroalimentaire. Chaque produit que nous consommons passe par une chaîne de contrôle qualité complexe. Or, dans de nombreux cas, l’évaluation repose encore sur l’œil humain : un processus coûteux, chronophage et subjectif. C’est particulièrement vrai pour la viande bovine. Un critère sensoriel essentiel est le persillé. Ces fines infiltrations de gras dans le muscle qui déterminent la jutosité, la tendreté et la flaveur de la viande. Aujourd’hui, son évaluation repose sur des notateurs accrédités qui attribuent une note de persillé en se basant sur un nuancier visuel. Deux échelles internationales de référence sont utilisées : AUS-MEAT (score de 0 à 9) et Meat Standards Australia (score de 100 à 1 190).

Si ces échelles sont reconnues mondialement, leur application en abattoir présente plusieurs limites : nécessité d’une formation continue et de remises à niveau, temps de notation significatif, variabilité entre évaluateurs. L’enjeu est donc de mettre au point des outils industriels rapides, fiables et non destructifs, capables de prédire automatiquement la note de persillé et d’autres critères (gras de couverture, rendement en viande), afin d’orienter les carcasses vers leurs marchés cibles avec une plus grande précision et transparence.

Contexte

La piste envisagée passe par l’exploitation de l’analyse d’images. En d’autres termes, utiliser des photos de la viande pour évaluer automatiquement le persillé grâce à des modèles de deep learning. Cette approche s’inscrit dans un contexte de modernisation du classement des carcasses. En Europe, la grille de classement EUROP (conformation/engraissement) ne prend pas en compte le persillé, alors même que ce critère sensoriel se révèle crucial pour la qualité de la viande. Or, plusieurs travaux ont montré l’importance de ce critère pour la qualité sensorielle des viandes, ce qui a conduit les filières françaises et européennes à réfléchir à son intégration dans les grilles de classement (Monteils et al., 2017).

Des technologies émergentes offrent aujourd’hui des alternatives prometteuses pour une évaluation objective et automatisée du persillé :

– la caméra Q-FOM™ Beef (Frontmatec), récemment validée par l’AUS-MEAT/MSA pour la prédiction du persillé ainsi que de la couleur de la viande et du gras (Mendes et al., 2025) ;

– des outils portables ou innovants tels que la spectroscopie proche infrarouge (NIRS) (capteurs INDIGO, capteurs embarqués sur smartphone), l’imagerie hyperspectrale (HSI, BBQ), la spectrométrie de masse REIMS ou encore les ultrasons (Mendes et al., 2024).

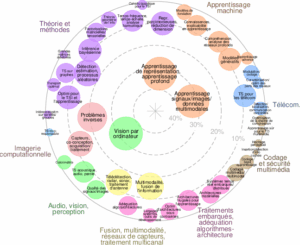

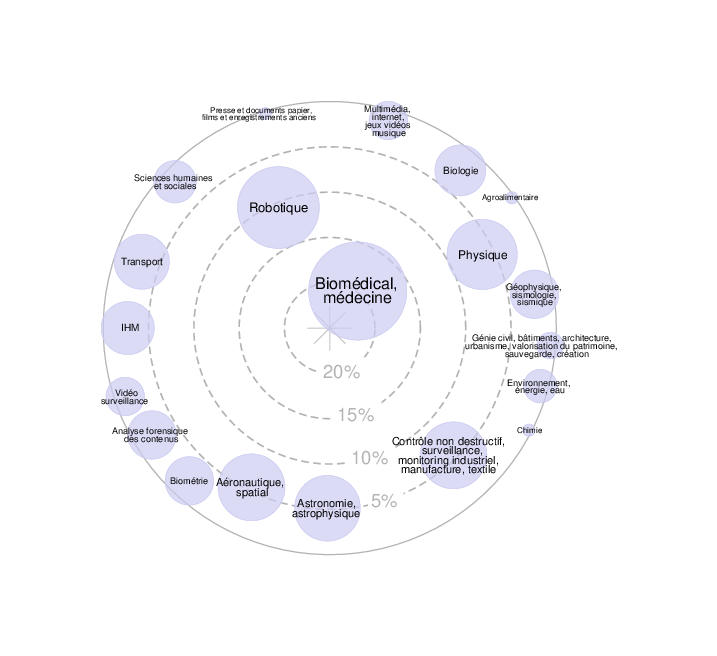

L’objectif du présent projet est d’évaluer le potentiel d’un autre type de modalité : l’imagerie couleur pour l’estimation du persillé de la viande à l’aide de modèles de deep learning. En effet, les méthodes d’apprentissage profond appliquées à l’analyse d’images offrent de nouvelles perspectives pour le traitement d’images texturées. Dans le cas des pièces de viande, elles vont permettre de reconnaitre des motifs visuels subtils tels le persillage (fines marbrures blanches dans la viande) et de mieux caractériser la qualité, là où les approches classiques peuvent atteindre leurs limites.

Déroulement du stage

Pour mener à bien ce travail, le stage s’articulera en cinq phases.

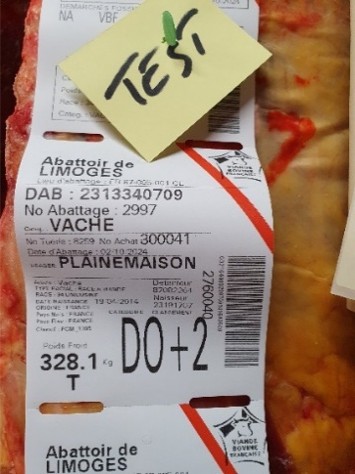

- Dans un premier temps, nous constituerons une base de données labellisées contenant des images de côtes de bœuf et d’étiquettes de pesée.

- Dans un deuxième temps, nous développerons un modèle de segmentation sémantique comme YOLOv11 (Khanam et al. 2024) permettant de reconnaitre le faux-filet (entouré en jaune dans la figure ci-dessus) à partir des images de côtes de bœuf.

- En se focalisant sur ce morceau de viande, un second modèle de deep learning sera développé pour évaluer le persillé de la viande. Une comparaison entre des approches de classification et de régression sera réalisée (Krizhevsky et al. 1012, He et al. 2016).

- Pour améliorer les performances prédictives de ces modèles, nous nous intéresserons à la prise en compte de métadonnées comme l’âge et la race du bœuf, le mode de conduite, etc. Ces métadonnées sont accessibles à partir du code barre présent sur l’étiquette de pesée. Pour cela, nous nous intéresserons à la lecture automatique de codes-barres dans un contexte fortement perturbé (présence de taches sur l’étiquette, encre effacée, etc.) et intègrerons ces métadonnées dans les modèles de prédictions en comparant différentes approches de fusion précoce ou tardive (Lu et al. 2021).

- Enfin, les modèles développés durant ce stage seront validés par des comparaisons avec d’autres approches de la littérature (Q-FOM™, NIRS, HSI).

Références

Mendes, N. da S. R., Briceno, J. C. C., Mársico, E. T., Ellies-Oury, M.-P., Chriki, S., Hocquette, J.-F., & de Oliveira, T. F. (2024). Recent technological developments and future trends in the evaluation and prediction of beef sensory quality in Brazil and France. Livestock Science, 287, 105550.

Mendes, N. da S. R., Christensen, M., Kombolo-Ngah, M., Faure, P., Thoumy, L., Neveu, A., Barro, A. G., Liu, J., de Oliveira, T. F., & Ellies-Oury, M.-P. (2025). Prediction of marbling score in ribeye quartered at the 5th-6th rib of French beef using the Q-FOMTM beef assessment camera. Meat Science, 222, 109759.

Monteils, V., Sibra, C., Ellies-Oury, M.-P., Botreau, R., De la Torre, A., & Laurent, C. (2017). A set of indicators to better characterize beef carcasses at the slaughterhouse level in addition to the EUROP system. Livestock Science, 202, 44–51.

Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet Classification with Deep Convolutional Neural Networks. Advances in Neural Information Processing Systems, 25, 1097-1105

He, K., Zhang, X., Ren, S., & Sun, J. (2016). Deep Residual Learning for Image Recognition. In Proc IEEE Comput Soc Conf Comput Vis Pattern Recognit (CVPR), 770-778.

Khanam, R., & Hussain, M. (2024). YOLOv11: An overview of the key architectural enhancements. arXiv preprint arXiv:2410.17725. https://arxiv.org/abs/2410.17725

Lu, M., Zhao, Q., Zhang, J., Pohl, K.M., Fei-Fei, L., Niebles, J.C., & Adeli, E. (2021) Metadata Normalization. Proc IEEE Comput Soc Conf Comput Vis Pattern Recognit (CVPR), 10912-10922

Profil recherché

- Vous êtes en dernière année d’un master ou école d’ingénieurs avec une spécialisation en traitement des images et/ou intelligence artificielle.

- Vous avez de bonnes connaissances en analyse d’images. En particulier, vous avez des connaissances sur le deep learning et les techniques d’apprentissage supervisé.

- Vous avez de solides compétences dans les langages de développement tels que Python et connaissez les principaux outils de l’intelligence artificielle (Pytorch).

- Vous êtes rigoureux et organisé, avec une appétence pour travailler dans un domaine interdisciplinaire (vision par ordinateur et production animale).

Organisation du stage et modalités de candidature

- Lieu du stage : Laboratoire IMS – Groupe Signal et Image, campus de Talence (33) et Bordeaux Sciences Agro (1, cours du Général de Gaulle, CS 40201 – 33175 Gradignan Cedex, France).

- Durée du stage : 5/6 mois à partir de février/mars 2026.

- Indemnité de stage selon la réglementation en vigueur.

- Envoyer par mail une lettre de candidature + un CV.

Contacts

- Lionel Bombrun, IMS/Bordeaux Sciences Agro, lionel.bombrun@ims-bordeaux.fr

- Jean-Pierre Da Costa, IMS/Bordeaux Sciences Agro, jean-pierre.dacosta@ims-bordeaux.fr

- John Albechaalany, Bordeaux Sciences Agro, john.albechaalany@agro-bordeaux.fr

Ce stage sera réalisé en collaboration avec Barna Keresztes (IMS/Bordeaux Sciences Agro) pour les aspects vision par ordinateur ainsi que Marie-Pierre Ellies et Sandrine Papillon (Bordeaux Sciences Agro) pour les enjeux applicatifs.