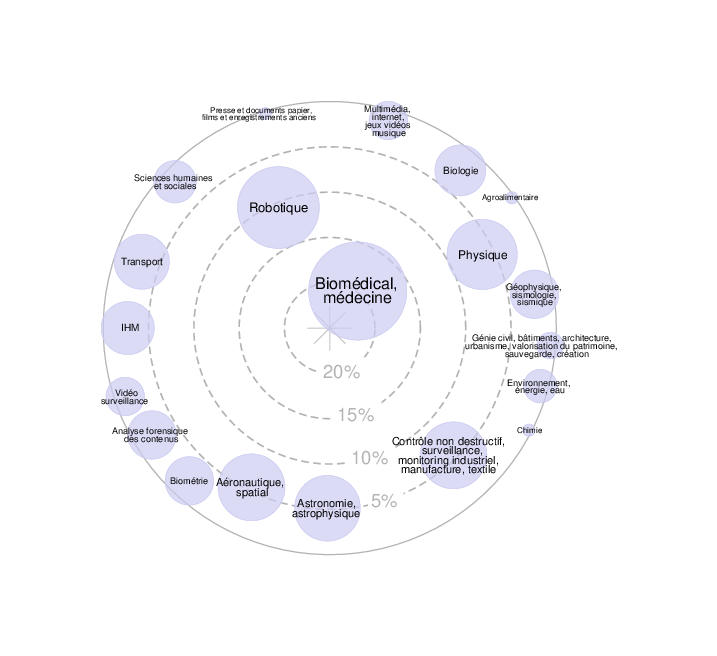

Contexte : Avec la montée en flèche de la création de contenus vidéo destinés aux enfants sur les plateformes en ligne (ex. YouTube Kids, Netflix Kids), la modération automatique de contenus multimédias est devenue un enjeu crucial.

Un contenu visuellement inoffensif peut toutefois inclure des éléments audios inappropriés (musiques, cris, sons agressifs, langage déplacé), difficilement détectables par des systèmes de modération unimodaux (basés uniquement sur l’image).

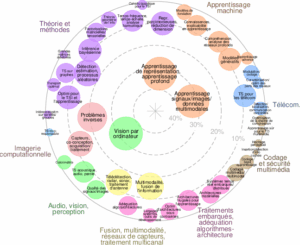

Les approches récentes de modération de contenu reposent sur des modèles de deep learning, souvent

centrés sur la vision (CNN, Vision Transformers) ou le langage (LLMs, CLIP), mais intègrent rarement la

modalité audio de manière explicite. Une intégration cohérente des modalités visuelle et sonore permettrait de mieux détecter les contenus potentiellement nuisibles pour les enfants, y compris lorsque les signaux problématiques ne sont présents que dans une seule modalité.

Dans ce cadre, le projet s’appuiera sur des ressources existantes telles que le jeu de données VHD11K

(GitHub : nctu-eva-lab/VHD11K), qui fournit une base vidéo annotée pour la détection de contenus nuisibles, et servira de point de départ pour développer un modèle de classification multimodal audio-visuel.

Sujet : L’objectif de ce stage est de concevoir, implémenter et évaluer un modèle de deep learning multimodal

capable de détecter des contenus nuisibles dans des vidéos destinées aux enfants.

Le projet comportera les axes suivants :

- Extraction et traitement des modalités visuelles (frames, embeddings d’images) et audio

(caractéristiques spectrales, embeddings audio type VGGish, AST, etc.). - Développement d’un modèle multimodal (basé sur des architectures de fusion, par ex. transformers

ou late fusion) pour combiner les deux modalités. - Évaluation comparative des approches unimodales (vision seule, audio seul) et multimodales (vision

- audio).

- Analyse qualitative et éthique : interprétation des décisions du modèle, étude des biais potentiels et

limites dans le contexte des vidéos pour enfants.

L’étudiant(e) pourra s’inspirer d’approches récentes de fusion multimodale (ex. CLIP, AudioCLIP, MMF,

VATT).

Plan de travail :

- Revue bibliographique : Modération de contenu multimodal (image, vidéo, audio), modèles de fusion

audio-visuelle récents, et spécificités du contexte « contenus pour enfants ». - Conception du pipeline multimodal : Pré-traitement des données audio et visuelles, et la

conception d’un modèle de fusion (early/late fusion, attention cross-modale).

- Apprentissage et évaluation : Entraînement sur le dataset adapté, comparaison unimodale vs

multimodale, et analyse des erreurs. - Interprétation et discussion : Visualisation des régions/sons contribuant à la décision, discussion

des biais, des enjeux éthiques et de la robustesse du modèle.

Profil recherché :

— Etudiant.e en Master 2 Recherche ou en dernière année d’école d’ingénieur, spécialisé en

informatique, image et/ou intelligence artificielle .

— Une formation en machine et deep learning est indispensable.

— Solides compétences en deep learning (PyTorch ou TensorFlow).

— Autonomie, rigueur et intérêt pour la recherche appliquée à la sécurité numérique et la protection des

enfants.

Candidature : Pour postuler, envoyer par email à l’encadrant un dossier comprenant un CV, une lettre de

motivation, les relevés de notes des deux dernières années de formation, ainsi que toute pièce susceptible de

renforcer la candidature (lettre de recommandation, etc.). - Références

- VHD11K Dataset and Benchmark for Harmful Video Detection, NCTU EVA Lab, GitHub :

https://github.com/nctu-eva-lab/VHD11K. - Hammad Ahmed et al. (2024). Enhanced Multimodal Content Moderation of Children’s Videos using

Audiovisual Fusion. FLAIRS 2024. - Chuttur, M.Y. et al. (2022). A Multi-modal Approach to Detect Inappropriate Cartoon Videos for

Children. Multimedia Tools and Applications. - NEGRE, Pablo, ALONSO, Ricardo S., GONZÁLEZ-BRIONES, Alfonso, et al. Literature Review of

Deep-Learning-based detection of violence in video. Sensors, 2024, vol. 24, no 12, p. 4016. - TAN, Dengtai, YANG, Yang, NIU, Chengyu, et al. A review of deep learning based multimodal forgery

detection for video and audio. Discover Applied Sciences, 2025, vol. 7, no 9, p. 987.