Mots-clés: vision par ordinateur, multimodalité, intelligence artificielle, journalisme de données

Contexte

Cette offre de thèse s’inscrit dans le cadre du projet « Fact Checking » mené depuis 2021 entre le laboratoire LIFAT et l’équipe PRIM [1][2][3][4]. Le fact checking, ou vérification de fait, consiste à vérifier la véracité des faits présentés dans les médias par des personnalités publiques ou autres organisations. De nombreux travaux de recherches ont été et sont en train d’être menés [5][6][7] pour répondre à l’enjeu majeur de la désinformation, notamment depuis l’avènement des technologies de deep-fake et d’IA génératives. Ce phénomène de désinformation massive est observable dans plusieurs domaines : on peut citer en particulier la sphère politique (« political discourse »), le changement climatique ou encore le domaine de santé (« COVID-19 misinformation »).

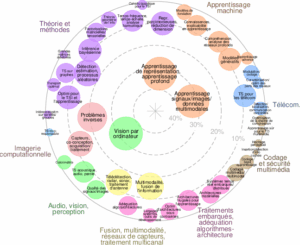

Au cours de la dernière décennie, des progrès significatifs ont été réalisés dans les domaines du « Computer Vision » (CV) et du « Natural Language Processing » (NLP), en grande partie grâce au succès des réseaux neuronaux. Ainsi, c’est tout naturellement que l’aspect multimodal (apprentissage conjointe des modalités) mêlant la CV et le NLP ont été étudiés récemment, avec succès dans des tâches telles que la réponse visuelle aux questions (VQA), le sous-titrage d’images ou de vidéos, etc.

Objectifs de la thèse

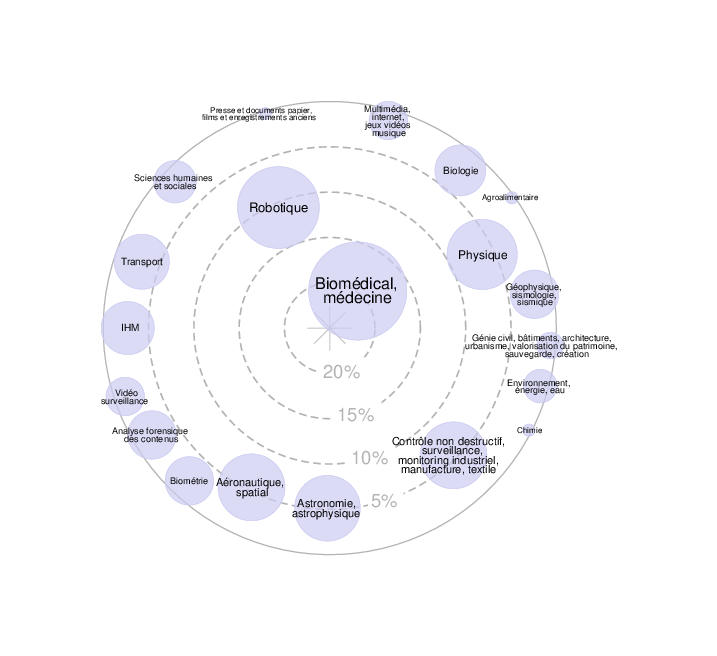

Cette thèse vise à la conception et à l’évaluation de nouvelles techniques de détection multimodale (vidéo, image, audio, texte) dans du contenu multimédia (vidéo, audio). Pour ce faire, la thèse explorera l’utilisation de concepts d’IA à différents niveaux « Audio-visual Active Speaker identification » (ASD), « Multimodal Named Entity recognition » (MNER), « Retrieval-Augmented Generation » (RAG), etc., et l’exploitation d’une base de données de fait vérifiés existante (base de données issue de [1], [4] ou benchmark existants).

Par ailleurs, compte-tenu de l’impact sociétal de ces travaux, un fort accent sera mis sur l’explicabilité des algorithmes multimodaux proposés, en agrégant différentes solutions : récupération d’information tierces via la recherche d’information, génération textuelle, visualisation d’élément saillant dans les images/vidéos, isolation des séquences d’intérêt dans les pistes audio/vidéos, etc.

Enfin, durant la réalisation de ces travaux de recherche, il s’agira aussi de tenir compte des verrous théoriques et empiriques de l’acception des citoyens d’un tel outil via les notions d’interactions avec les outils développés, et de visualisation interactive et d’ergonomie. Ces aspects seront abordés via une collaboration avec des chercheurs en sciences de l’information et de la communication ou des journalistes et fact-checkers.

Informations complémentaires

Date de début : octobre 2025 (durée de 3 ans)

Financement : cette bourse de thèse est financée par la Région Centre Val de Loire

Rémunération : environ 27k€ brut annuel

Encadrement: la thèse sera dirigée par Nicolas RAGOT (PR) – Directeur de thèse – https://www.univ-tours.fr/annuaire/m-nicolas-ragot , Frédéric RAYAR (MCF) – Encadrant – http://frederic.rayar.free.fr/, Mathieu DELALANDRE (MCF) – Encadrant – http://mathieu.delalandre.free.fr/

Localisation

La thèse sera effectuée à l’Université de Tours, au sein de l’équipe Reconnaissance de Formes et Analyse

d’Images (http://www.rfai.lifat.univ-tours.fr/) du laboratoire LIFAT (https://lifat.univ-tours.fr/).

Idéalement située au cœur de la France (Val de Loire), à une heure de Paris et à 2 heures 30 de l’océan

Atlantique, Tours est une ville vivante et dynamique.

Profil recherché

- M2 en informatique ou diplôme d’ingénieur

- Bonnes connaissances en Machine Learning et Intelligence Artificielle

- Bonnes connaissances en programmation indispensables

- Des compétences en développement web sont souhaitables

- Bonnes capacités de communication et de rédaction, en particulier en anglais

Candidature

Le dossier de candidature doit être envoyé par mail à Frédéric RAYAR (frederic.rayar At univ-tours.fr) avant

le 01/06/2025 et doit être constitué de :

– CV ;

– Lettre de motivation – contenant les motivations pour ce sujet en particulier ;

– Résultats depuis la M1 (ou 1ere année d’école d’ingénieur) ;

– Lettre(s) de recommandation(s) ;

– Rapport de stage et/ou articles scientifiques – de préférence en lien avec les thématiques

scientifiques du présent sujet.

Bibliographie (indicative)

[1] Rayar F. FrenchFacts: A French Dataset of Fact-Checked Claims. In Proceedings of the 2024 Joint

International Conference on Computational Linguistics, Language Resources and Evaluation (LREC-COLING).

2024 (Accepted).

[2] Rayar F. Fact-Checked Claim Detection in Videos Using a Multimodal Approach. In Proceedings of the

19th International Joint Conference on Computer Vision, Imaging and Computer Graphics Theory and

Applications (VISAPP), 614-620. 2024.

[3] Rayar F. et Nicey J. Détecter et contextualiser le faux dans les énoncés politiques en télévision :

conception d’un dispositif multimodal de vérification. Infox sur Seine. 2023.

[4] Rayar F., Delalandre M., and Le V-H. A large-scale TV video and metadata database for French political

content analysis and fact-checking. In Proceedings of the 19th International Conference on Content-based

Multimedia Indexing (CBMI), 181–185. 2022

[5] Guo, Z., Schlichtkrull, M., and Vlachos, A. A survey on automated fact-checking. Transactions of the

Association for Computational Linguistics, 10:178. 2023.

[6] Akhtar M., Schlichtkrull M., Guo, Z., Cocarascu, O., Simper E., and Vlachos, A. Multimodal automated fact-

checking: A survey. 2023

[7] Kotonya, N. and Toni, F. Explainable automated fact-checking: A survey. CoRR, abs/2011.03870. 2020