Contexte du stage

Ce projet s’inscrit dans le cadre de la recherche en écohydraulique. Il vise à faire progresser notre compréhension des mécanismes d’adaptation comportementale des poissons aux caractéristiques physiques des écoulements dans les passes à poissons et les ouvrages de franchissement piscicole. En effet, bien qu’il est avéré que les écoulements influencent de manière significative les comportements locomoteurs des poissons et affecte leur capacité à se déplacer, un manque de connaissance sur l’effet des caractéristiques de l’écoulement sur le comportement du poisson est actuellement relevé dans la littérature.

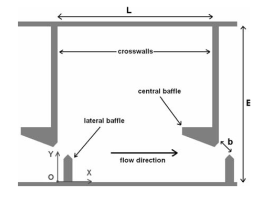

L’équipe Hydée de l’institut Pprime travaille depuis plusieurs années sur l’étude numérique et expérimentale des écoulements dans des canaux turbulents et passes à poissons. Elle dispose pour cela d’une plateforme hydrodynamique environnementale qui comprend 2 dispositifs expérimentaux : un canal turbulent et une passe à poissons à fente verticale sur lesquels il est possible de faire varier les configurations des écoulements et d’acquérir des vidéos des poissons selon un ou deux point de vue.

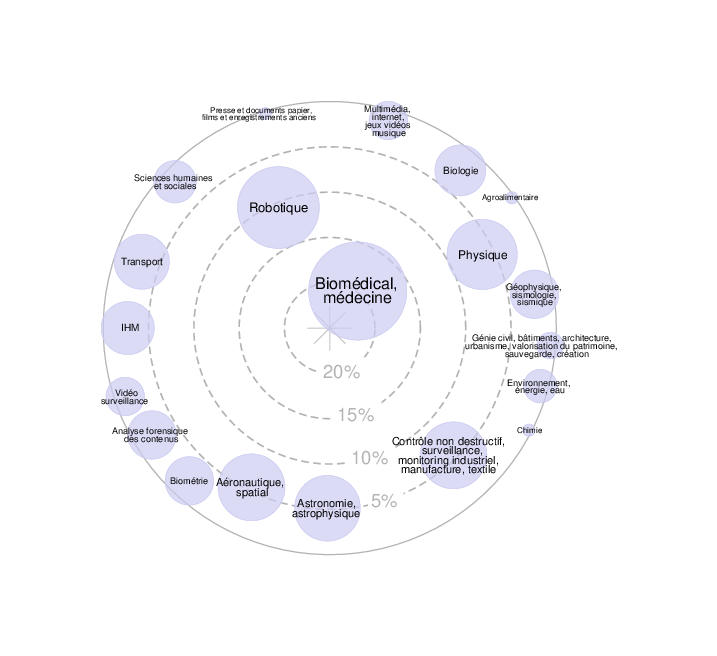

Afin d’étudier le comportement des poissons, l’équipe Hydée souhaiterait mettre en place des méthodes avancées de traitement d’images et de vision par ordinateur. Le système développé devra permettre tout d’abord de détecter le poisson et sa position, puis de recaler un modèle paramétrique 3D de formes (maillage) sur le poisson pour ensuite extraire les caractéristiques de nage (amplitude et fréquence de battement des nageoires, orientation du corps, etc.) en lien avec des modèles mathématiques de mouvement. L’estimation de paramètres physiologiques tels que la longueur, le poids, la fréquence de battement des branchies est aussi envisagée. La détection des positions permettra de suivre les trajectoires des poissons dans des conditions variées. L’ acquisition d’un grand nombre de vidéos présentant une grande variété de conditions complexes (ombres, bulles d’eau, artefacts d’arrière-plan, eau plus ou moins chargée, poissons partiellement visibles…) permettra d’alimenter une base de données comprenant les trajectoires, les caractéristiques de nages, des paramètres physiologiques, des simulations numériques associées à différents modèles de passe à poissons et différentes espèces de poissons. Finalement, le système devra être capable à partir de cette base d’apprentissage de prédire les trajectoires des poissons. Ce qui permettra de déterminer l’efficacité du modèle de passe à poisson vis-à-vis de la taille du poisson et de ses capacités de nage.

Le stage est financé par la fédération de recherche MIRES (Mathématiques & leurs Interactions, Images & information numérique, Réseaux et Sécurité) FR CNRS 3423.

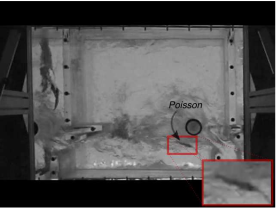

Dans le cadre du stage, nous nous concentrerons sur la détection et l’étude des trajectoires de poissons dans des vidéos acquises en surplomb d’un bassin d’une passe à poisson (cf Figure ci-dessous).

Résumé du travail proposé

La plupart des méthodes de suivi d’objets mettent en œuvre un suivi par détection. Cela consiste tout d’abord à détecter les objets dans chaque trame de la vidéo puis d’associer les détections en mettant en correspondance la position, l’apparence ou les caractéristiques de mouvements des objets au cours de la vidéo. Les méthodes les plus utilisées jusqu’il y a une dizaine d’années étaient les méthodes de Lucas&Kanade [1], à base de noyau : Mean-shift [2], cam-shift [3], les contours actifs, filtres de Kalman [4-5], filtres particulaires [6-7]…

L’introduction de méthodes de deep learning à la fois pour détecter et extraire les caractéristiques d’apparence a permis le développement de nouvelles méthodes dont DeepSORT [8], ByteTrack [9], BoTSORT [10], SMILETrack [11]… qui affichent de très bonnes performances dans des conditions d’acquisition complexes. Ainsi, très récemment certaines de ces méthodes ont été appliquées et adaptées au suivi de poissons [12-15]. Néanmoins, à notre connaissance aucune de ces méthodes a été appliquée à l’étude des trajectoires des poissons dans des passes à poissons.

L’approche envisagée pour ce stage comporte plusieurs étapes : 1) faire une étude bibliographique des méthodes de suivi par détection et plus particulièrement celles appliqués au suivi de poissons ; 2) proposer une méthode de suivi et d’analyse des trajectoires des poissons robuste aux conditions complexes d’acquisition de l’expérience. Il s’agira notamment de de compter les nombre de succès et d’échec de franchissement de bassin et pour les succès le parcours et entre des zones de repos éventuelles ; 3) comparer la méthode à une ou plusieurs méthode de l’état de l’art et analyser les résultats.

Mots-clefs

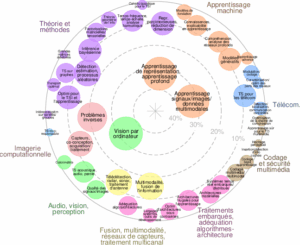

Vision par ordinateur, suivi multi-objets, analyse de trajectoires, apprentissage profond.

Prérequis et contraintes particulières

L’étudiant devrait être inscrit à un niveau de Master 2 Informatique ou Traitement du Signal

/Image ou intelligence artificielle ;

Investissement, rigueur, méthode et esprit d’initiative ;

L’étudiant devra être capable d’implanter les algorithmes proposés en C++ et/ou Python ;

Une bonne connaissance des bibliothèques d’intelligence artificielle Scikit-Learn, PyTorch et TensorFlow sera un plus.

Références bibliographiques :

[1] Baker, S., Matthews, I., 2004. Lucas-Kanade 20 years on: a unifying framework. Int. J. Comput. Vis. 56 (3), 221-255 .

[2] Comaniciu, D., Ramesh, V., Meer, P., 2003. Kernel-based object tracking. IEEE Trans.PAMI 25 (5), 564-575.

[3] Bradski, G.R., 1998. Computer vision face tracking for use in a perceptual user interface. Intel Technol. J. Q2.

[4] Broida, T.J., Chellappa, R., 1986. Estimation of object motion parameters from noisy images. IEEE Trans. PAMI 8 (1), 90-99.

[5] Bewley, A., Ge, Z., Ott, L., Ramos, F., & Upcroft, B. (2016, September). Simple online and realtime tracking. In 2016 IEEE international conference on image processing (ICIP) (pp. 3464-3468). IEEE.

[6] Isaard, M., Blake, A., 1998. CONDENSATION-conditional density propagation for visual tracking. Int. J. Comput. Vis. 29 (1), 5-28.

[7] Quéré, R., Péteri, R., 2011. Suivi robuste de poissons dans des passes à poissons par filtrage particulaire et transformée en curvelets. Presented at the 23ème colloque GRETSI.

[8] Wojke, N., Bewley, A., & Paulus, D. (2017, September). Simple online and realtime tracking with a deep association metric. In 2017 IEEE international conference on image processing (ICIP) (pp. 3645-3649). IEEE.

[9] Zhang, Y., Sun, P., Jiang, Y., Yu, D., Weng, F., Yuan, Z., … & Wang, X. (2022, October). Bytetrack: Multi-object tracking by associating every detection box. In European Conference on Computer Vision (pp. 1-21). Cham: Springer Nature Switzerland.

[10] Aharon, N., Orfaig, R., & Bobrovsky, B. Z. (2022). BoT-SORT: Robust associations multi-pedestrian tracking. arXiv preprint arXiv:2206.14651.

[11] Wang, Y. H. (2022). SMILEtrack: SiMIlarity LEarning for Multiple Object Tracking. arXiv preprint arXiv:2211.08824.

[12] Li, W., Liu, Y., Wang, W., Li, Z., Yue, J., 2024. TFMFT: Transformer-based multiple fish tracking. Computers and Electronics in Agriculture 217, 108600. https://doi.org/10.1016/j.compag.2023.108600

[13] Liu, Y., Li, B., Zhou, X., Li, D., Duan, Q., 2024. FishTrack: Multi-object tracking method for fish using spatiotemporal information fusion. Expert Systems with Applications 238, 122194. https://doi.org/10.1016/j.eswa.2023.122194

[14] Wang, H., Zhang, S., Zhao, S., Wang, Q., Li, D., Zhao, R., 2022. Real-time detection and tracking of fish abnormal behavior based on improved YOLOV5 and SiamRPN++. Computers and Electronics in Agriculture 192, 106512. https://doi.org/10.1016/j.compag.2021.106512

[15] Wang, Z., Xia, C., Lee, J., 2021. Parallel Fish School Tracking Based on Multiple Appearance Feature Detection. Sensors 21, 3476. https://doi.org/10.3390/s21103476

Encadrants

Benoit TREMBLAIS

Laboratoire XLIM, UMR CNRS 7252

Téléphone : +33(0)5 49 49 65 90

benoit.tremblais@univ-poitiers.fr

Renaud PETERI

Laboratoire MIA, EA EA 3165, Université de La Rochelle

Téléphone : +33(0)5 46 45 72 19

Laurent MASCARILLA

Laboratoire MIA, EA EA 3165, Université de La Rochelle

Téléphone : +33(0)5 46 45 87 43

Informations complémentaires

Lieu du stage

Ce stage se déroulera au laboratoire XLIM UMR CNRS 7252 sur le site de Poitiers au sein de l’équipe ICONES/ASALI dont l’adresse est la suivante :

Laboratoire XLIM, UMR CNRS 7252

Bât. SP2MI, Téléport 2,

Bvd Marie et Pierre Curie, BP 30179

86962 Futuroscope Chasseneuil Cedex France