L’émergence des deepfakes et des techniques de face swapping a profondément transformé le paysage de la cybersécurité visuelle. Grâce aux modèles génératifs comme les GANs et les modèles de diffusion, il est désormais possible de produire des vidéos hyperréalistes dans lesquelles le visage d’un individu est remplacé par celui d’un autre, de manière quasiment indétectable à l’oeil humain.

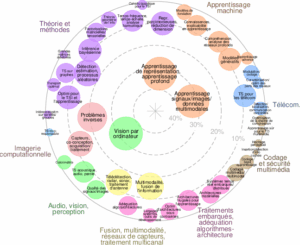

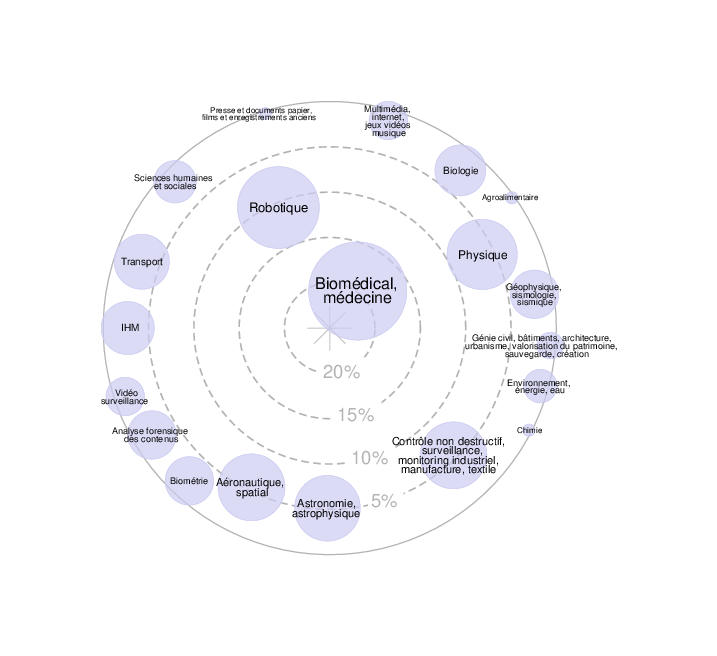

Face à cette menace, de nombreux modèles de détection automatique de deepfakes ont été développés, exploitant des architectures de vision profonde telles que les Convolutional Neural Networks (CNN), les Vision Transformers (ViT) ou encore des modèles spatio-temporels. Ces systèmes cherchent à repérer des artefacts subtils produits par les algorithmes de génération (incohérences d’éclairage, artefacts de compression, déformations locales du visage, etc.).

Cependant, ces détecteurs restent vulnérables à un nouveau type de menaces : les attaques adversariales. Celles-ci consistent à ajouter une perturbation quasi imperceptible à une image afin de tromper un modèle d’intelligence artificielle. Parmi elles, les perturbations adversariales universelles (UAP) représentent une forme avancée d’attaque, car un seul bruit généré peut tromper un modèle sur un grand nombre d’images, voire sur un flux vidéo entier.

L’objectif principal de ce stage est d’évaluer la robustesse des détecteurs de deepfake. Pour cela vous serez amené à concevoir et évaluer des perturbations adversariales universelles (UAP) capables de tromper des modèles de détection de deepfakes tout en restant visuellement imperceptibles.

Ce stage d’une durée de 4 à 6 moins à compter du 01 avril, s’adresse à des étudiant.e.s de niveau M2 ou dernière année d’école d’ingénieur ayant de solides connaissances en apprentissage profond et réseaux neuronaux, notamment les GANs avec une expérience en vision par ordinateur et traitement d’images et des compétences en programmation (Python, TensorFlow ou PyTorch).

Encadrants : Christophe Charrier (PR Unicaen – christophe.charrier@unicaen.fr) et Emmanuel Giguet (CR CNRS – emmanuel.giguet@unicaen.fr)

Pour postuler, envoyer par email aux encadrants un dossier avec CV, lettre de

motivation, relevés de notes des deux dernières années de formation, ainsi que toute

pièce susceptible de renforcer la candidature (lettre de recommandation, etc.).

Vous pouvez consulter le document joint pour avoir plus d’information.