Réunion

Solutions matérielles pour la fusion de données

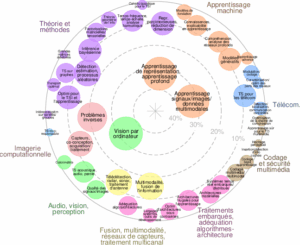

Axes scientifiques :

- Fusion, multimodalité , réseaux de capteurs, traitement multicanal

- Adéquation algorithme-architecture, traitements embarqués

Organisateurs :

- - Virginie Fresse (LaHC)

- - Audrey Giremus (IMS Bordeaux)

Nous vous rappelons que, afin de garantir l'accès de tous les inscrits aux salles de réunion, l'inscription aux réunions est gratuite mais obligatoire.

Inscriptions

16 personnes membres du GdR IASIS, et 18 personnes non membres du GdR, sont inscrits à cette réunion.

Capacité de la salle : 50 personnes. 16 Places restantes

Inscriptions closes pour cette journée

Annonce

Programme

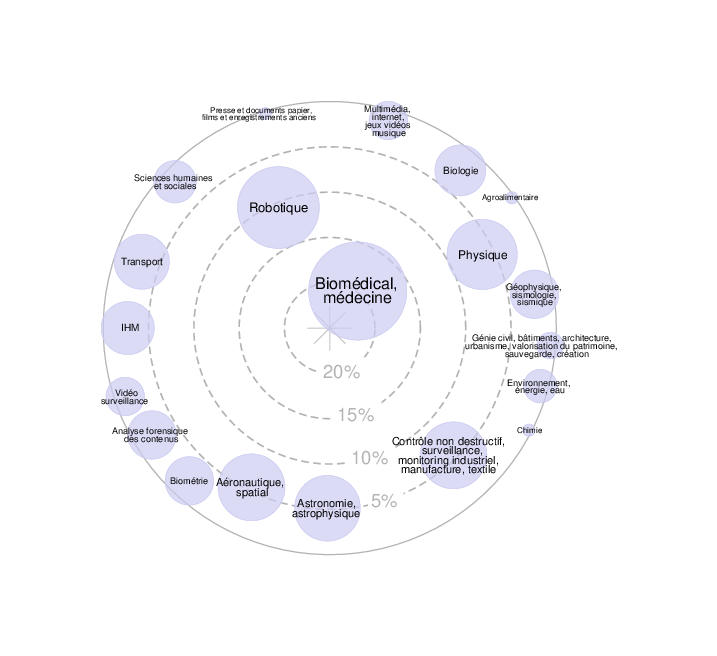

La fusion de données constitue un enjeu central dans l’amélioration de la perception, de l’analyse et de la prise de décision dans de nombreux domaines : systèmes embarqués, surveillance environnementale, industrie 4.0, santé, robotique, etc. Elle permet, par la combinaison de données issues de sources multiples, d’obtenir une information plus riche, robuste et fiable que celle fournie par une seule source.

Dans ce contexte, une journée scientifique est consacrée aux thèmes :

- Conception et déploiement de capteurs ou réseau de capteur pour la fusion de données,

- Prétraitement de données pour une fusion pertinente et performante,

- Algorithmes exploitant la fusion de données.

Une attention particulière sera portée aux travaux illustrant comment la fusion de données est intégrée dès la conception de nouveaux capteurs, algorithmes ou systèmes, en lien avec des problématiques concrètes ou applicatives.

Orateurs invités :

- Sylvain Saighi (IMS),

- Pauline Trouvé et Kevin Helvig (ONERA),

- Yves Bringer (Archipel).

Emplacement : amphi 160 de l'ESIEE Paris, Université Gustave Eiffel, Cité Descartes, 2 boulevard Blaise Pascal, 93160 Noisy-le-Grand.

Programme détaillé :

9h45 - 10h : accueil des participants.

10h-10h45 : exposé de Kevin Helvig et Pauline Trouvé (ONERA), "Fusion infrarouge-visible par attention croisée pour la détection d'objets".

10h45-11h30 : exposé de Yves Bringer (Archipel), "Caméras neuromorphiques".

11h30-11h50 : exposé d'Augustin Borne (French-German Research Institute of Saint-Louis), "Suivi visuel multi-modal de cibles sur système embarqué".

*********************

12h-14h : pause déjeuner.

*********************

14h-14h45 : exposé de Sylvain Saighi (IMS Bordeaux), "IA et soutenabilité énergétique".

14h45-15h05 : exposé de Camel Tanougast (Université de Lorraine), "De l’exploration à l’exploitation : une approche améliorée du Q-Learning pour la robotique autonome".

15h05-15h25 : exposé de Florian Fizaine (LEAD Dijon), "Réseaux Spike appliqués à l'IA pour pour le déchiffrage des archives de Moyen-Âge du Duché de Bourgogne".

15h25-15h45 : exposé de Mohamad Jouni (GIPSA Lab), "RGB-Guided Snapshot Hyperspectral Super-resolution: A Dual-camera System and Pipeline".

15h45 : conclusion de la journée.

Informations pratiques pour la demande de prise en charge des missions :

merci de consulter la page https://uncloud.univ-nantes.fr/index.php/s/S5DA2MFY4tnrZzz qui détaille les conditions d'inscription et de prise en charge des frais de déplacement (les informations nécessaires à la prise en charge de mission doivent être transmises avant le 12 septembre 17h).

Organisatrices :

- Virginie Fresse (LaHC, Saint Etienne) virginie.fresse@univ-st-etienne.fr

- Audrey Giremus (IMS, Bordeaux) audrey.giremus@u-bordeaux.fr

Résumés des contributions

Exposé de Kevin Helvig et Pauline Trouvé

Titre : "Fusion infrarouge-visible par attention croisée pour la détection d'objets"

Résumé : Le couplage entre différentes modalités (visible/infrarouge/radar…) peut permettre d’améliorer significativement la performance des modèles de détection d’objet par apprentissage profond. Chacune des sources d’informations peut en effet présenter des propriétés spécifiques utiles suivant le contexte d’observation, tels que les objets chauds en détection de nuit. Cependant, construire des architectures fusionnant efficacement de multiples canaux d’information n’est pas simple : équilibre entre taille de l’architecture et performance finale, efficience des opérations de fusion … Les modèles basés sur l’attention, via leur capacité à apprendre des corrélations longue distance et multi-échelles dans les données d’entrée, ouvrent de nouvelles possibilités de fusion entre des caractéristiques extraites dans différentes modalités. Nous présenterons le développement d’une architecture utilisant l’attention croisée afin de combiner des cartes de caractéristiques monospectrales (CAFF) pour les Transformers de Détection (DETR-DINO). Les résultats obtenus par cette approche de fusion sur des benchmarks de fusion infrarouge-visible ainsi qu'une mise en application sur données expérimentales seront présentés. Cette dernière couple l'information visible et l'information infrarouge pour la détection de fissures sur matériaux métalliques par thermographie laser : sur cette quantité de données plus limitée, l'apprentissage est de plus amélioré à l'aide de modèles génératifs de diffusion.

Exposé d'Yves Bringer

Titre : "Les caméras neuromorphiques"

Résumé : Les caméras neuromorphiques s'inspirent du fonctionnement de l'œil humain. Contrairement aux caméras classiques, elles ne capturent pas des images entières à intervalles réguliers, mais détectent uniquement les changements de luminosité pixel par pixel, avec une résolution temporelle inférieure à 100 microsecondes. Cela permet une vitesse extrême, une consommation ultra-faible et une réduction massive de données. Idéales pour les environnements dynamiques, elles sont utilisées, par exemple, dans les voitures autonomes, les prothèses rétiniennes ou l’analyse de mouvements rapides.

Exposé d'Augustin Borne

Titre : "Suivi visuel multi-modal de cibles sur système embarqué"

Résumé : Le suivi d’objets depuis des drones constitue une tâche cruciale de vision par ordinateur pour les applications militaires, notamment pour la reconnaissance, la surveillance et le guidage de munitions. L’exploitation conjointe des modalités visible et thermique (RGB‑T) permet aux algorithmes de suivi de surmonter les conditions difficiles rencontrées sur le terrain. D’une part, nous avons développé un modèle de suivi RGB‑T reposant sur un Vision Transformer et intégrant une combinaison d’imagerie Bayer et thermique. Grâce à une méthode de distillation capable d’extraire les connaissances d’un modèle RGBT, nous obtenons des performances prometteuses, bien que des travaux supplémentaires soient nécessaires pour atteindre les performances l’état de l’art. D’autre part, afin d’évaluer ces algorithmes, nous avons créé un dataset à partir d’une plate-forme UAV équipée d’un système de capteurs RGB‑T. Nous avons collecté des séquences aériennes complexes (contre‑mesures, camouflage, conditions météorologiques difficiles, variations d’illumination) et testé plusieurs méthodes issues de la littérature. Nous avons également mis au point un algorithme de référence combinant un modèle de l’état de l’art avec une fusion RGB-T au niveau pixel. Les travaux futurs viseront le développement d’une architecture logicielle robuste, optimisée pour les contraintes d’embarquabilité.

Exposé de Sylvain Saighi

Titre : "IA et soutenabilité énergétique"

Résumé : Aujourd’hui tout le monde s’accorde sur l’omniprésence de l’Intelligence Artificielle (IA) dans notre quotidien. Cependant, l’IA gérée actuellement par les GAFAM (Google, Amazon, Facebook, Apple et Microsoft) est décentralisée sur des serveurs. Sachant que la consommation électrique de l’Internet représente 5% de la production mondiale (rapport 2023 de l'Agence Internationale de l'Energie) et que le trafic Internet augmente de 25% par an, il faut d’ores et déjà envisager des solutions de calcul alternatives faute de désillusion. S’inspirer du vivant a toujours fait partie des techniques de l’Homme pour répondre à des problèmes d’ingénierie. Sachant que le cerveau humain consomme 20W, plusieurs équipes dans le monde pensent qu’une solution résiderait dans la réalisation d’architectures neuromorphiques (réseaux de neurones artificiels matériels). De plus les progrès récents des sciences des matériaux ont permis de proposer plusieurs solutions pour réaliser des neurones ou des synapses (memristors, spintronique, isolants de Mott, etc..). La présentation proposera un éclairage sur la conception neuromorphique et de ses retombées attendues.

Exposé de Camel Tanougast

Titre : "De l’exploration à l’exploitation : une approche améliorée du Q-Learning pour la robotique autonome"

Résumé : La problématique de la mobilité autonome dans des environnements complexes nécessite des techniques de planification de trajectoires capables de déterminer, en temps réel, un chemin optimal entre la position courante d’un robot et sa destination. Cette présentation explore l’apport des méthodes de Reinforcement Learning (RL), particulièrement adaptées à l’apprentissage dynamique de l’environnement par des systèmes autonomes. Nous proposons une variante du Q-Learning, nommée TRE-QL (Tailored Reward and Epsilon-Greedy Decay QL), reposant sur deux améliorations clés : (i) une fonction de récompense adaptée afin de favoriser l’exploration de nouvelles trajectoires plutôt que la reproduction de chemins sous-optimaux, et (ii) une stratégie de décroissance progressive du paramètre ε dans la politique epsilon-greedy, assurant une transition fluide entre exploration et exploitation. L’analyse expérimentale montre que TRE-QL améliore significativement la vitesse de convergence et la capacité d’apprentissage dans des environnements complexes. Ces résultats ouvrent des perspectives prometteuses pour la conception d’agents embarqués, où l’efficacité doit être conciliée avec les contraintes de complexité algorithmique, de précision et de consommation énergétique.

Exposé de Mohamad Jouni (travail conjoint mené par Mohamad Jouni, Amaury Nègre, Aurélien Godet, Mauro Dalla Mura)

Titre : "RGB-Guided Snapshot Hyperspectral Super-resolution: A Dual-camera System and Pipeline."

Résumé :

Snapshot hyperspectral imaging is valuable in domains such as agriculture, security, surveillance, and waste sorting, but current cameras face trade-offs between spatial resolution, spectral resolution, and cost. A promising alternative is to pair a low-resolution hyperspectral sensor with a low-cost, high-resolution RGB camera and fuse their data. We present a dual-camera demonstrator for snapshot hyperspectral super resolution guided by a low-cost RGB camera. The system is implemented in ROS2, which orchestrates the full pipeline from data acquisition and preprocessing to registration and spectro-spatial fusion. Its design enables the evaluationof diverse fusion strategies in a reproducible and extensible framework. This work illustrates a pathway toward integrated hardware–software solutions for multimodal real-time fusion, contributing to the democratization of hyperspectral technology for practical applications.